Obsah

Práca SEO optimalizátora je veľmi rozsiahla. Začínajúcim špecialistom sa odporúča zapísať si optimalizačný algoritmus tak, aby nevynechali žiadne fázy. V opačnom prípade bude ťažké označiť propagáciu za úspešnú, pretože stránka bude neustále zaznamenávať zlyhania a chyby, ktoré bude potrebné dlho opravovať.

Jednou z fáz optimalizácie je práca s robotmi.txt súbor. Každý zdroj by mal mať tento dokument, pretože bez neho bude ťažšie zvládnuť optimalizáciu. Vykonáva mnoho funkcií, ktoré budete musieť pochopiť.

Robot Assistant

Robot.súbor txt je dokument vo formáte obyčajného textu, ktorý je možné zobraziť v štandardnom poznámkovom bloku systému. Pri jeho vytváraní musíte nastaviť kódovanie UTF-8 tak, aby sa správne čítalo. Súbor pracuje s protokolmi http, https a FTP.

Tento dokument je pomocníkom pri vyhľadávaní robotov. Ak neviete, potom každý systém používa "pavúky", ktoré rýchlo skenujú World Wide Web, aby poskytli relevantné stránky požiadavkám používateľov. Tieto roboty musia mať prístup k údajom o zdrojoch, roboty na to pracujú.txt.

Aby "pavúky" našli cestu, musíte robotom poslať dokument.txt do koreňového adresára. Ak chcete skontrolovať, či stránka obsahuje tento súbor, zadajte "https://site.com.UA / roboty.txt". Namiesto " stránky.com.ua", musíte zadať zdroj, ktorý potrebujete.

Funkcie dokumentu

Robot.súbor txt poskytuje vyhľadávacím robotom niekoľko typov informácií. Môže poskytnúť čiastočný prístup, aby "pavúk" skenoval konkrétne prvky zdroja. Úplný prístup vám umožňuje skontrolovať všetky dostupné stránky. Úplný zákaz nedáva robotom možnosť dokonca začať kontrolovať a opustia stránku.

Po návšteve zdroja dostanú "pavúky" príslušnú odpoveď na žiadosť. Môže ich byť niekoľko, všetko závisí od informácií v robotoch.txt. Napríklad, ak bolo skenovanie úspešné, robot dostane kód 2xx.

Je možné, že na webe bolo nainštalované presmerovanie z jednej stránky na druhú. V tomto prípade robot dostane kód 3xx. Ak sa tento kód vyskytne niekoľkokrát," pavúk " ho bude nasledovať, kým nedostane ďalšiu odpoveď. Aj keď spravidla používa iba 5 pokusov. V opačnom prípade sa zobrazí populárna chyba 404.

Ak je odpoveď 4xx, robot môže skenovať celý obsah stránky. V prípade kódu 5xx sa však kontrola môže úplne zastaviť, pretože to často naznačuje dočasné chyby servera.

Na čo slúžia roboty?.txt?

Ako ste možno uhádli, tento súbor je sprievodcom robota ku koreňu stránky. Teraz sa používa na čiastočné obmedzenie prístupu k nežiaducemu obsahu:

- stránky s osobnými údajmi užívateľov;

- zrkadlové stránky;

- výsledky vyhľadávania;

- formuláre na odosielanie údajov atď.

. Ak v koreňovom adresári stránky nie je žiadny súbor robotov.txt, potom robot naskenuje úplne všetok obsah. V dôsledku toho sa na výstupe môžu objaviť nežiaduce údaje, čo znamená, že vy aj Stránka budete trpieť. Ak v dokumente roboty.txt má špeciálne pokyny, čo znamená, že "pavúk" ich bude nasledovať a poskytne informácie požadované vlastníkom zdroja.

Práca so súborom

Použitie robotov.txt ak chcete zatvoriť stránku z indexovania, musíte zistiť, ako vytvoriť tento súbor. Postupujte podľa pokynov:

- Vytvorte dokument v programe Poznámkový blok alebo poznámkový blok++.

- Inštalovať príponu súboru ".txt".

- Zadajte potrebné údaje a príkazy.

- Uložte dokument a nahrajte ho do koreňového adresára stránky.

Ako vidíte, v jednej z etáp je potrebné nastaviť príkazy pre roboty. Sú dvoch typov: povoliť (Povoliť) a zakázať (zakázať). Niektoré optimalizátory môžu tiež určiť rýchlosť prehľadávania, hostiteľa a odkaz na mapu stránky zdroja.

Aby ste mohli začať s robotmi.txt a úplne zatvorte stránku z indexovania, je tiež potrebné pochopiť Použité symboly. Napríklad v dokumente môžete použiť "/", čo znamená, že je vybratá celá stránka. Ak sa použije"*", vyžaduje sa postupnosť znakov. Týmto spôsobom bude možné určiť konkrétny priečinok, ktorý je možné skenovať alebo nie.

Zvláštnosť robotov

"Pavúk" vo vyhľadávačoch sú rôzne, takže ak pracujete pre niekoľko vyhľadávacích nástrojov naraz, budete musieť tento bod vziať do úvahy. Ich názvy sú rôzne, čo znamená, že ak sa chcete odvolávať na konkrétneho robota, budete musieť zadať jeho názov: "User Agent: Yandex" (bez úvodzoviek).

Ak chcete nastaviť smernice pre všetky vyhľadávacie nástroje, musíte použiť príkaz :" User Agent: * " (bez úvodzoviek). Aby to bolo správne pomocou robotov.txt zatvorte stránku z indexovania, musíte zistiť špecifiká populárnych vyhľadávacích nástrojov.

Faktom je, že najobľúbenejšie vyhľadávacie nástroje Yandex a Google majú niekoľko robotov. Každý z nich sa zaoberá vlastnými úlohami. Napríklad Yandex Bot a Googlebot sú hlavnými "pavúkmi", ktoré skenujú web. Keď poznáte všetkých robotov, bude jednoduchšie doladiť indexovanie vášho zdroja.

Napríklad

Takže pomocou robotov.txt stránku môžete zavrieť pred indexovaním pomocou jednoduchých príkazov, hlavnou vecou je pochopiť, čo potrebujete špeciálne. Napríklad, ak chcete, aby sa robot Google nepriblížil k vášmu zdroju, musíte mu dať príslušný príkaz. Bude to vyzerať takto: "User-agent: Googlebot Disallow: /" (bez úvodzoviek).

Teraz musíme zistiť, čo je v tomto tíme a ako to funguje. Takže "User-agent" sa používa na použitie priameho odvolania na jedného z robotov. , Potom určíme, ktorý z nich je v našom prípade Google. Príkaz "zakázať" by mal začínať od nového riadku a zakázať robotovi vstup na stránku. Symbol lomky v tomto prípade znamená, že na vykonanie príkazu sú vybraté všetky stránky zdroja.

V robotoch.zákaz indexovania txt pre všetky vyhľadávacie nástroje je možné vykonať jednoduchým príkazom: "User-agent: * Disallow: /" (bez úvodzoviek). Symbol hviezdičky v tomto prípade označuje všetky vyhľadávacie roboty. Zvyčajne je takýto príkaz potrebný na pozastavenie indexovania stránky a začatie kardinálnej práce na nej, čo by inak mohlo ovplyvniť optimalizáciu.

Ak je zdroj veľký a má veľa stránok, často existujú servisné informácie, ktoré je buď nežiaduce zverejniť, alebo môžu negatívne ovplyvniť propagáciu. V tomto prípade musíte pochopiť, ako nakupovať stránka z indexovania v robotoch.txt.

Môžete skryť priečinok alebo súbor. V prvom prípade musíte začať znova kontaktovaním konkrétneho robota alebo všetkých, preto použijeme príkaz "User-agent" a nižšie zadáme príkaz "zakázať" pre konkrétny priečinok. Bude to vyzerať takto: "zakázať: / folder/" (bez úvodzoviek). Týmto spôsobom skryjete celý priečinok. Ak je v ňom nejaký dôležitý súbor, ktorý by ste chceli zobraziť, musíte napísať príkaz nižšie: "povoliť: / folder/.php súbor " (bez úvodzoviek).

Kontrola súboru

Ak používate roboty.txt podarilo sa vám zavrieť stránku Pred indexovaním, ale neviete, či všetky vaše smernice fungovali správne, môžete skontrolovať správnosť práce.

Najprv musíte znova skontrolovať umiestnenie dokumentu. Pamätajte, že musí byť výlučne v koreňovom priečinku. Ak sa dostal do koreňového priečinka, nebude to fungovať. Ďalej otvorte prehliadač a zadajte tam nasledujúcu adresu:" http://вашсайт. com / robots.txt "(bez úvodzoviek). Ak sa vo webovom prehliadači objaví chyba, znamená to, že súbor nie je tam, kde by mal byť.

Smernice je možné skontrolovať v špeciálnych nástrojoch, ktoré používajú takmer všetci správcovia webu. Hovoríme o produktoch Google a Yandex. Napríklad v službe Google Search Console je panel nástrojov, kde musíte otvoriť "skenovanie" a potom spustiť " nástroj na overenie súborov robotov.txt". V okne musíte skopírovať všetky údaje z dokumentu a spustiť skenovanie. Presne rovnakú kontrolu je možné vykonať v " Yandex.Webmaster".

Ako vytvoriť obchodnú stránku na facebook: podrobné pokyny, tipy a odporúčania

Ako vytvoriť obchodnú stránku na facebook: podrobné pokyny, tipy a odporúčania Aktivácia sim karty beeline: príkaz, podrobné pokyny, tipy a odporúčania

Aktivácia sim karty beeline: príkaz, podrobné pokyny, tipy a odporúčania Ako poslať súbor do cloudu: pokyny a odporúčania

Ako poslať súbor do cloudu: pokyny a odporúčania Ako zmeniť úvodnú stránku v yandex.prehliadač: pokyny

Ako zmeniť úvodnú stránku v yandex.prehliadač: pokyny Nastavenieyandex.yandex. Trh: podrobné pokyny, tipy, odporúčania a recenzie

Nastavenieyandex.yandex. Trh: podrobné pokyny, tipy, odporúčania a recenzie Kam zavolať, keď bolo auto evakuované? Odporúčania, pokyny krok za krokom

Kam zavolať, keď bolo auto evakuované? Odporúčania, pokyny krok za krokom Ako obnoviť odstránenú stránku v kontakte: pokyny a metódy

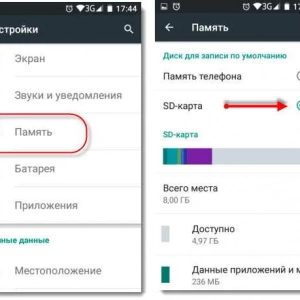

Ako obnoviť odstránenú stránku v kontakte: pokyny a metódy Ako presunúť aplikáciu pre android na kartu sd: podrobné pokyny a odporúčania

Ako presunúť aplikáciu pre android na kartu sd: podrobné pokyny a odporúčania Ako dať laminátové podlahy na podlahu: podrobné pokyny, tipy a odporúčania špecialistov

Ako dať laminátové podlahy na podlahu: podrobné pokyny, tipy a odporúčania špecialistov